Sesleri ve görüntüleri kullanan yeni içerik, üretken yapay zeka (üretken yapay zeka) sahtekarlığında yeni bir çağ başlatmış gibi görünüyor.

Şüpheli görünen e-postaların yerini, yakınlarınızın sesi ve görüntüsüyle sizi arayıp para isteyen yazılımlar alırken, rızanız olmadan üretilen videolardan para kazanma vakaları da her geçen gün artıyor.

İnsan seslerini ve görüntülerini taklit eden deepfake dolandırıcılıklarına karşı araçlar geliştirilirken, teknolojideki hızlı ilerlemeler “ebedi bir kedi-fare oyunları çağını” başlatmış olabilir.

DEEPFAKE NEDİR, NASIL KULLANILIR?

Deepfake, kullanım alanları her geçen gün çeşitlenen ve gelişen bir teknolojidir. Yapay zeka ile gerçekçi görüntü veya ses üretimine olanak sağlar.

Bugün Deepfake’in mükemmel ufuk açıcı kullanımları geliştirilmeye devam ediyor.

Örneğin bu yaz, San Francisco’daki Kaliforniya Üniversitesi ve Amerika Birleşik Devletleri’ndeki (ABD) Berkeley’deki araştırmacılar, 18 yıldır felçli olan bir hastanın, beyin implantı ve yapay aletler yardımıyla ilk kez “konuşmasına” olanak sağladı. istihbarat.

Ekip, 2005 yılındaki düğününde kaydedilen bir videoyu kullanarak hastanın sesini yeniden sentezledi.

Gelecek vaat eden araştırmalara bakıldığında, deepfake’in kötü amaçlı kullanımlarda yeni bir çağ başlattığı görülüyor.

Mayıs ayında Çin’in kuzeyinde yaşanan bir dolandırıcılık vakasında, Baotou şehrinin polisi, deepfake kullanan bir saldırganın, kurbanın arkadaşı gibi davranarak sahte video görüşmesi yoluyla 622.000 dolar para transferi yaptığını duyurdu.

Mağdur, ihale sürecinde arkadaşının depozito yatırması gerektiğine inandığı için parayı transfer ettiğini söyledi.

Deepfake’in mali suçlarda kullanılması, saldırıların hedef kitlesinin yalnızca dijital okuryazar nüfus olmadığını göstermesi açısından önemlidir.

KİMLER HEDEF OLABİLİR?

Bugün, deepfake yazılımını indirebilir ve yalnızca birkaç saat içinde sahte bir video veya ses üretebilirsiniz.

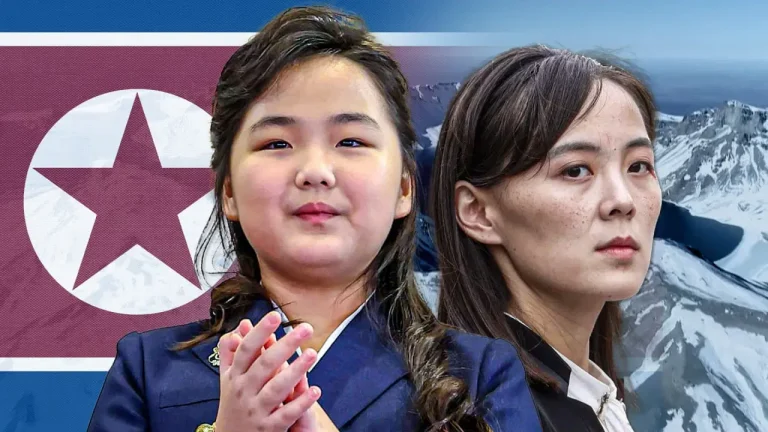

Ünlüler, sosyal medya fenomenleri ya da ürettikleri, görüntüleri ya da sesleri internette bulunan içeriklerden para kazananlar deepfake saldırılarının ilk hedefi olabiliyor.

Ancak kötü niyetli kullanımlar çok daha geniş bir kitleyi etkiliyor ve herkesi aynı şekilde etkilemiyor.

Örneğin kadınların rızası olmadan özel görüntüler üretme riski daha yüksek görünüyor.

BBC TürkçeOxford Üniversitesi İnternet Enstitüsü’nde yapay zeka konusunda etik ve yasalar uzmanı olan Prof.’un sorularını yanıtlıyor. Sandra Wachter, deepfake’lerin zararlı kullanımının cinsiyet boyutuna dikkat çekiyor:

“Teknoloji sıklıkla kadınların rızası olmayan mahrem görüntülerini yaymak ve itibarlarını zedeleyecek karalama kampanyaları yapmak için kötüye kullanılıyor.”

Saldırılar aynı zamanda küçük çocukları ve okul çağındaki kızları da etkiliyor.

Bu hafta başında Amerika Birleşik Devletleri’nin doğu ve batı bölgelerindeki iki farklı okulda üretilen ve dağıtılan derin sahte çıplak kız görüntülerinin kurbanı olan aileler, yapay zekanın zararlarına karşı daha sert yasal önlemler istediklerini söylüyorlar.

Sahte görüntülerin yanı sıra sahte ses üretimindeki gelişmeler de yeni güvenlik açıklarına ilişkin soruları gündeme getiriyor.

BBC TürkçeAlmanya’daki Münih Ludwig Maximilian Üniversitesi Bilgisayarlı Görü ve Öğrenme Grubu Başkanı Prof. Dr.’nin sorularını yanıtlıyor. Björn Ommer, sahte sesin “özellikle sorunlu bir saldırı türü olabileceğini, çünkü alıcıya orijinalliği doğrulamak için nispeten sınırlı seçenekler bıraktığını” söylüyor.

Deepfake’in ürettiği sahte sesler, günümüzde sesli kimlik doğrulama sistemlerini kullanan şirketleri de tehdit ediyor.

İngiltere’deki Waterloo Üniversitesi’ndeki araştırmacılar, deepfake ses kullanarak ses kimlik doğrulama sistemlerini kandırmak için yalnızca altı denemede %99 başarı oranına ulaştıklarını açıkladı.

Araştırmacılar, kimlik doğrulamak için yalnızca müşterilerinin sesini kullanan şirketlerin daha güçlü önlemler alması gerektiği konusunda uyardı.

Ayrıca nüfusun yaşlı kesimi, akrabalarının seslerini çoğaltmak ve onlardan para istemek için deepfake kullanan saldırılara karşı daha fazla risk altında olabilir.

Profesör. Ommer, “Buradaki hedefler yüksek tanınırlığa sahip kişiler değil, medya/dijital okuryazarlığı minimum düzeyde olan kişilerdir” diyor.

Profesör. Ommer bunu, konuşma sentezindeki son gelişmelerin saatlerce süren ses kayıtları yerine yalnızca birkaç örnekle eğitim modellerine odaklandığını belirterek açıklıyor.

Deepfake, sosyal medyada hızla yayılan ve neredeyse tüm internet kullanıcılarını etkileyen dezenformasyon kampanyalarının da bir parçası olabiliyor.

Oxford Üniversitesi’nde profesör. Sandra Wachter, “Sorun şu ki herkes etkileniyor” diyor.

“Siyasetçiler ve devlet başkanları, dezenformasyon yayabilecek ve seçim süreçlerini etkileyebilecek potansiyel hedeflerdir.

“Teknoloji, barışı ve demokrasiyi etkileyen savaşlarla ilgili sahte haberlerin ve komplo teorilerinin yayılması için kullanılıyor.

“Kesinlikle bir dürüstlük krizi içindeyiz. Gerçek, kurgu ve sahteyi birbirinden ayırmak zorunda kalmak yeni bir şey olmasa da, gözlerimizi ve kulaklarımızı bu kadar ikna edici bir şekilde kandıran teknolojiye hiç sahip olmamıştık.”

DEEPFAKE DOLANDIRICILIĞINDAN KAÇINMAK MÜMKÜN MÜ?

İnternet kullanıcılarını sahte ses ve videolardan koruduğunu veya sahte videoları tespit ettiğini iddia eden çevrimiçi araçlar bulunmaktadır.

Ancak bu araçların çoğunun kullanımının kolay veya yaygın olduğunu söylemek zordur.

Üstelik uzmanlara göre günümüzün en önemli zorluklarından biri de yapay zekanın gelişim hızı.

Sahte sesler üreten derin sahte yazılımlara karşı koruma sağlayan yazılım geliştiren St. Louis’deki Washington Üniversitesi’nde bilgisayar bilimi ve mühendisliği alanında yardımcı doçent. Yardımcı Dr. Ning Zhang, BBC Türkçe‘a “Tamamen güvenli bir sistem yok” diyor.

Sesi bambaşka bir teoriyle sentezleyecek yeni teknolojilerle karşı karşıya kalındığında koruma uygulamalarının da buna göre uyarlanması gerekiyor” diye ekliyor.

Aynı senaryo, sahte görüntüler üreten yapay zeka yazılımları için de geçerli ve sahte içerik giderek daha inandırıcı hale geliyor.

Oxford Üniversitesi’nde profesör. Wachter, “Sanırım bazılarının sahte içerik oluşturacağı, diğerlerinin ise bu içeriği tespit edip işaretleyecek teknolojiler yaratacağı ebedi kedi-fare oyunu çağına giriyoruz” diyor.

Profesör. Wachter, “yanlış içeriği tespit edebilecek %100 güvenilir bir sisteme sahip olmanın hiçbir zaman mümkün olmayacağına” inandığını söylüyor ve ekliyor:

“Fakat bu bizim cesaretimizi kırmamalı. Ne zaman birisi duvar örse, başka biri de onun üzerinden atlamak isteyecektir.

“Yapabileceğimiz tek şey (sahte) tespit yazılımına yatırım yapmak, tetikte ve eleştirel kalmak.”

Eleştirel ve sorgulayıcı olmak, internette gördüğümüz sahte içeriklerin yayılmasını engelleyebileceği gibi, bir yakınının sesinden şüpheli telefon alan kişinin bu aramayı doğrulamasını ve belki de kendisine para ödenmesini de engelleyebilir. hayatı boyunca tasarruf yaptı. yanlış ellere düşmekten.

Bireysel çabaların, insanları yanlış içeriklerden kaynaklanabilecek olası zararlardan koruyan hukuk kurallarıyla desteklenmesi gerekmektedir.

Profesör. Wachter, “Gelecekte, yapay zeka içeriğinin ‘filigranlanmasını’ yasal olarak zorunlu kılmak ve bu işaretlerin kaldırılmasına ceza uygulamak da önemli olacak” diyor.

Bu yıl Avrupa Birliği’nden Amerika Birleşik Devletleri’ne kadar birçok grup ve OpenAI ve Google gibi teknoloji şirketleri, yapay zeka içeriğinin filigranlarla işaretleneceği sözünü verdi.

Birleşik Krallık’ta Lordlar Kamarası’nda sunulan Çevrimiçi Güvenlik Yasası, rıza dışı deepfake porno görüntülerinin paylaşılmasını yasa dışı kılıyor.

Ancak yasal düzenlemelerin yapay zeka gelişiminin hızına ayak uydurup yetişemeyeceği henüz belli değil.